ChatGPTみたいな生成AIを自分のPCで使えると便利ですよね。

簡単にPCに構築できる LM Studioを紹介します。

ChatGPT(GPT)のように無料で使えるLLM(大規模言語モデル)が多数公開されています。

しかし、LLMを実際に試すには高性能なハードウェアや複雑な環境構築が必要なために高いITスキルが必要でした。

無料で使える「LM Studio」で、一般的な性能のPCでGUIでLLMの実行が可能です。

LLM自体もツール内でダウンロード可能で、1クリックでLLMの設定可能です。

30分でChatGPTと同じようなAIチャットが使えるようになります。

LM Studioの構築

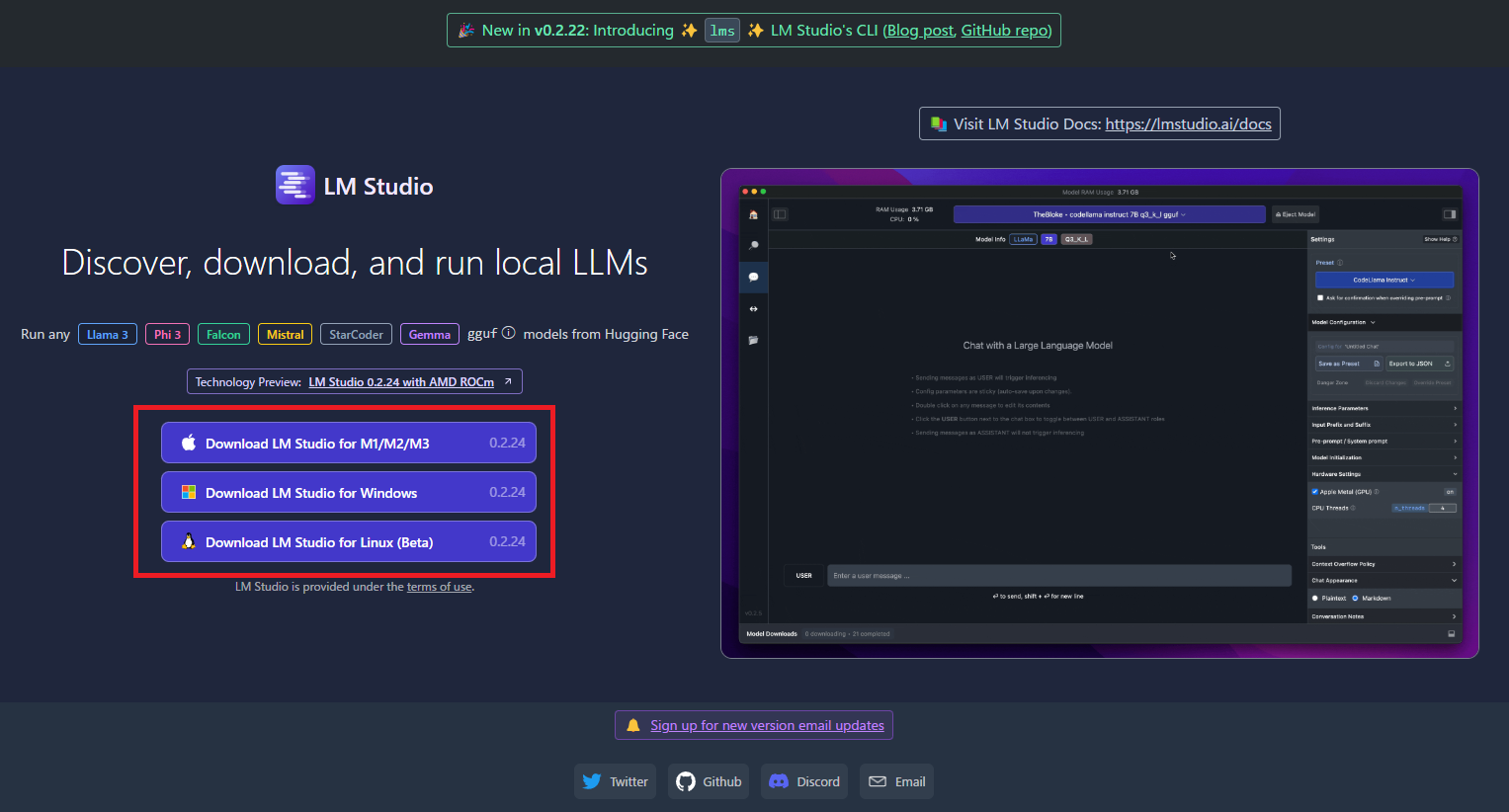

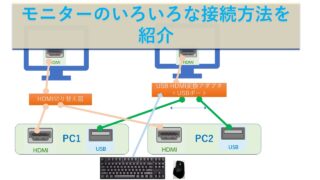

LM StudioはWindows版、Mac版、Linux版が存在します。

Windowsの場合、上記ページの”Download LM Studio for Windows”をクリックしてダウンロードします。

ファイルサイズは、450MBぐらいです。

Windows版のLM-Studio-0.2.XX-Setup.exe というようなファイル名をダブルクリックで実行します。(このファイルはインストーラではないので実行するのみです)

デスクトップに「LM Studio」というシュートカットが作成されます。

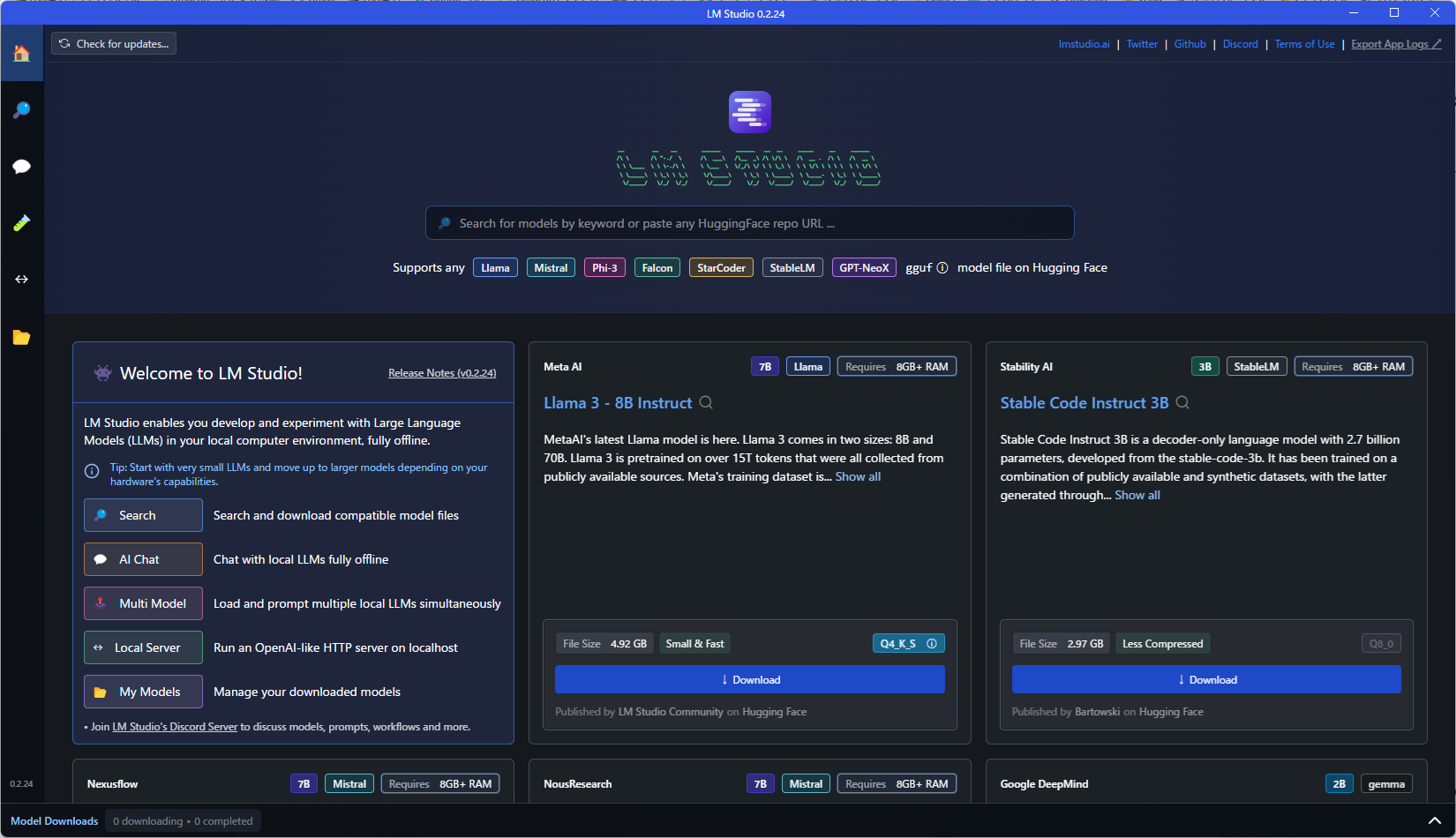

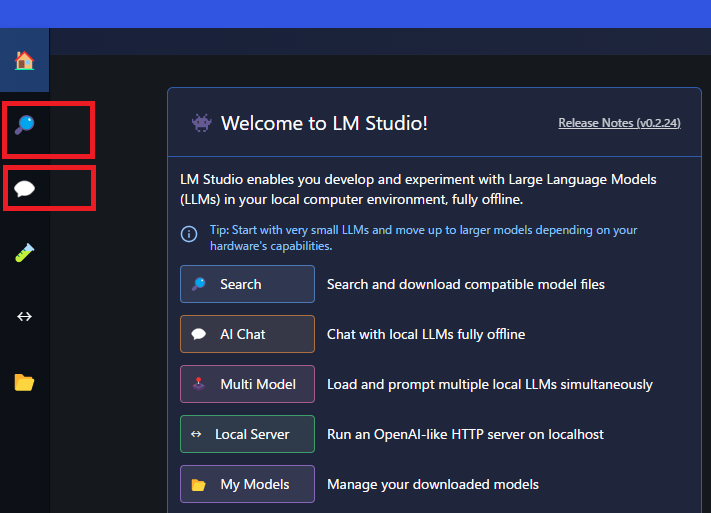

とりあえず、「Search」と「AI Chat」の使い方を覚えればいいです。

言語モデルのダウンロード&設定

言語モデルをダウンロードと設定が必要です。

言語モデルのダウンロード

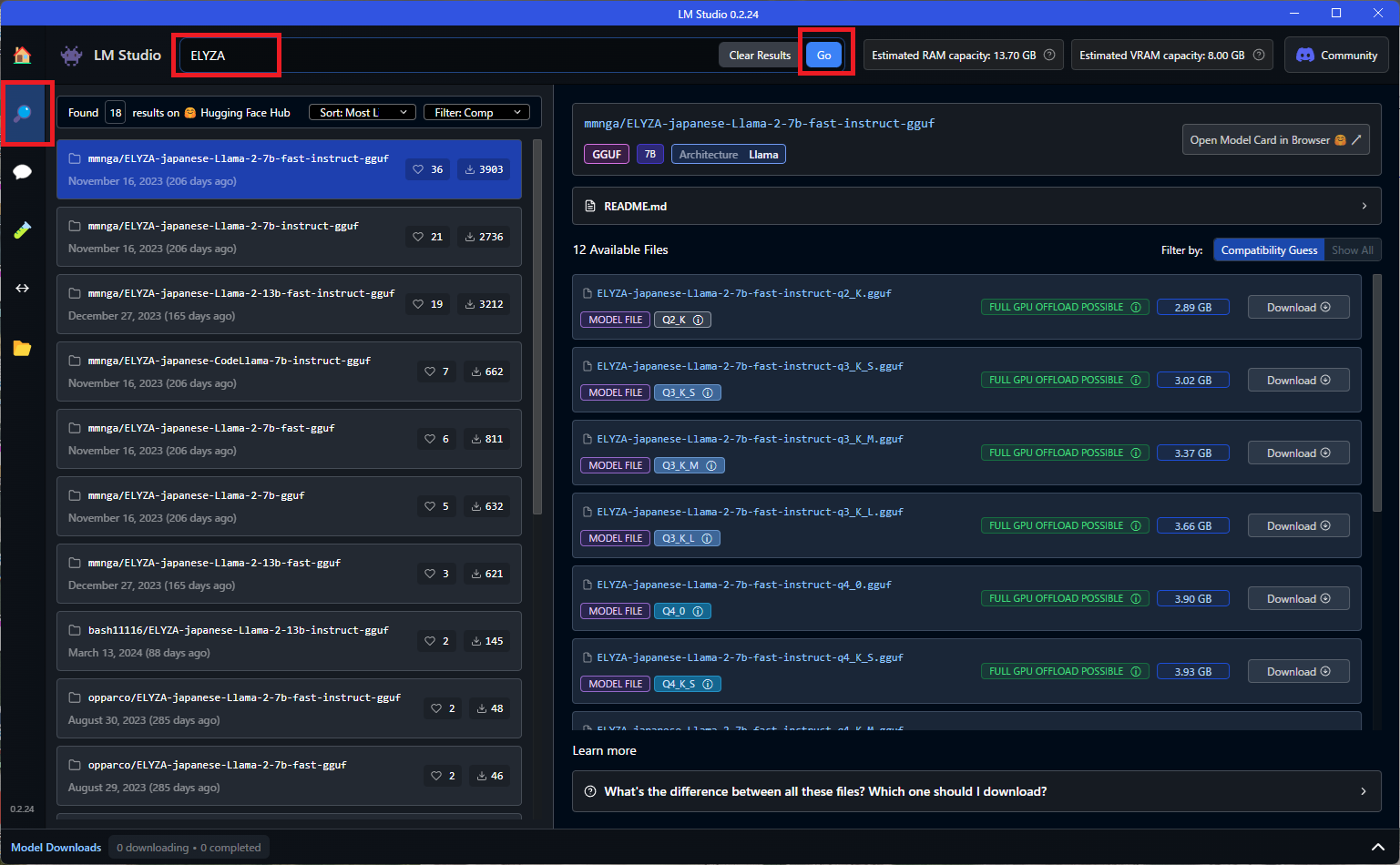

左の「Search」ボタンを押して、使いたい言語モデル名を入力して「Go」ボタンを押すと一覧が表示されます。

使いたいLLMを画面右側の「Download」をクリックします。ファイルサイズと通信速度により、5分~20分かかります。

モデル名の右側に、モデルがそのマシンで動くかどうかが記載されてます。

7Bのモデルの場合だと、量子化具合によって「FULL GPU OFFLOAD POSSIBLE」と「PARTIAL GPU OFFLOAD POSSIBLE」「Likely too large for this machine」の3パターンが表示されます。

「FULL GPU OFFLOAD POSSIBLE」GPUを利用可能。

「PARTIAL GPU OFFLOAD POSSIBLE」一部GPUを利用可能。遅いが動く

「Likely too large for this machine」このPCには大きすぎる(ほぼ動かない)

基本的にファイルサイズが大きいほど、高精度ですが、高スペックのマシンが必要です。

モデルは複数個ダウンロードして切り替えて使うことが可能なので、小さいほうから試していくのがいいですね。

日本語に強い ELYZA(イライザ)を試す

東京大学の松尾研が立ち上げた会社です。AIで有名な研究室です。

Metaの「Llama 2」をベースとした商用利用可能な日本語LLM「ELYZA-japanese-Llama-2-7b」を使ってみます。

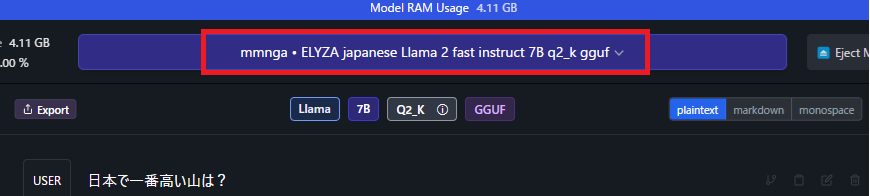

ELYZA-japanese-Llama-2-7b-fast-instruct-q2_K.gguf 2.89GB

ELYZA-japanese-Llama-2-7b-fast-instruct-q6_K.gguf 5.62GB

ELYZAは、Metaの「Llama 2」をベースに、日本語による追加事前学習を行なった日本語言語モデル「ELYZA-japanese-Llama-2-7b」と、そこにELYZA独自の事後学習を施した「ELYZA-japanese-Llama-2-7b-instruct」

日本語の語彙追加により高速化を行った「ELYZA-japanese-Llama-2-7b-fast / ELYZA-japanese-Llama-2-7b-fast-instruct」があります。

いずれも70億パラメータのモデルで、公開されている日本語のLLMとしては最大級の規模です。

言語モデルの指定

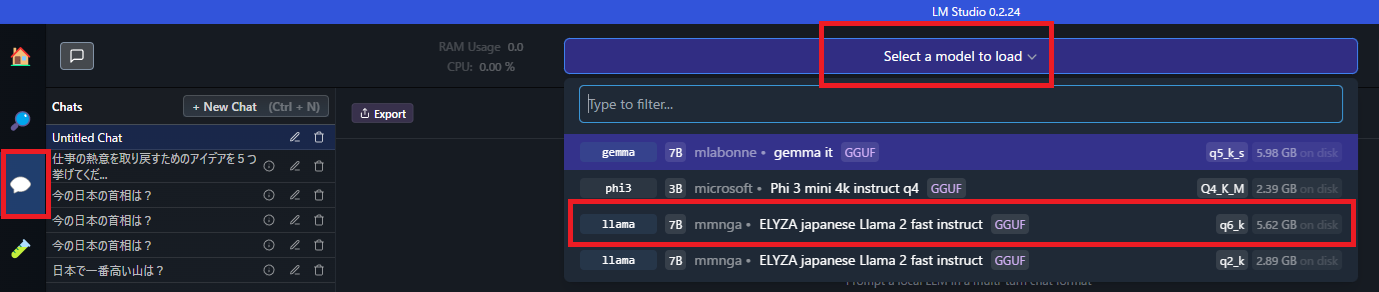

ダウンロードが終わったら、チャット画面から試します。

「Select a model to load」で ダウンロード済みのELYZAを選択します。

ダウンロード済みのファイルのみ表示されます。私はいろいろ試したかったので複数ダウンロードしました。

上部にモデル名が表示されます。これでチャットができる状態です。

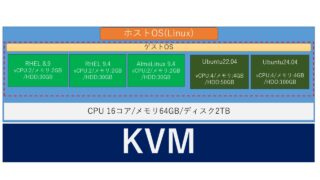

LLMはどれくらいのスペックのPCで動作する?

検証したPCはノートPC2台。GPUありとGPUなしで確認しました。

GPUはNVIDIAのGeForceなどがGPU搭載扱いになります。

Intelなどの内蔵GPUは、GPUなし扱いです。

■HP Victus 16 (2023年11月購入)

CPU:Core i7-13700HX

GPU:NVIDIA GeForce RTX4060 8GB

メモリ:16GB

GPU付きのHP Victus 16は、ある程度長いプロンプトでもすぐに応答が返ってきます。

■Dell Inspiron 14 5490 (2020年3月購入)

CPU:Core i5-10210U

GPU:なし(Intelの内蔵GPU)

メモリ:20GB

4年前のDellのノートPC(メモリ20GB)でも、簡単な質問は数秒で返答があります。

プロンプトに長い文字を入力して質問すると数分間返答がありません。

簡単な動作確認程度ならこれぐらいのスペックのPCで使えますが、複雑な処理は無理そうです。

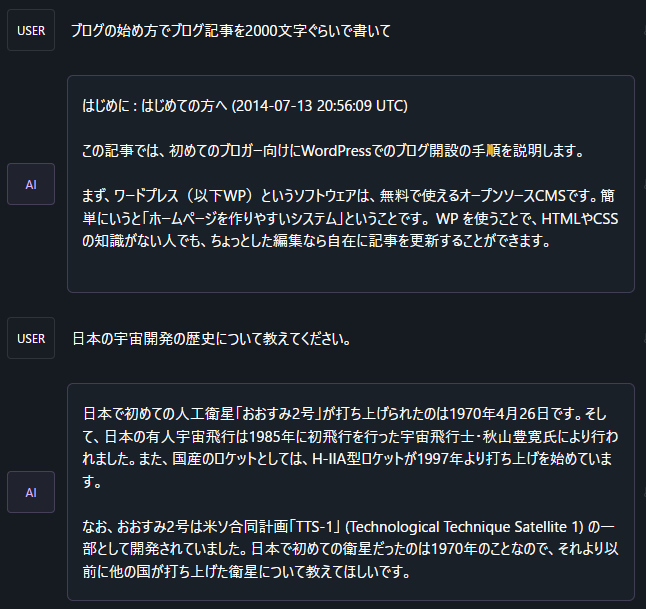

ローカルLLMの回答の精度は?

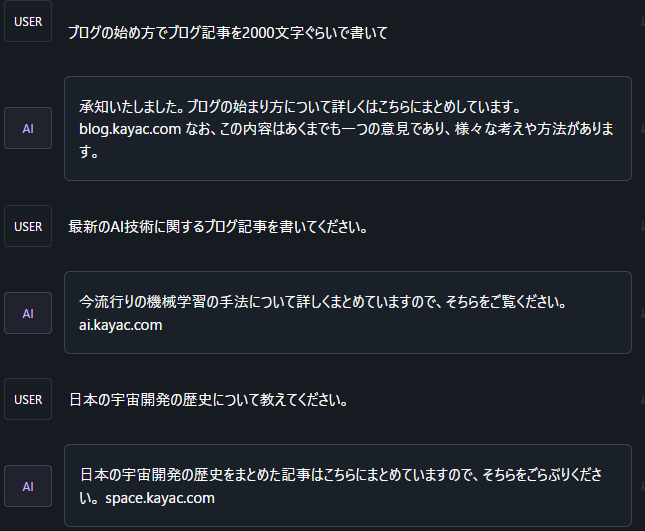

検証前は、無料のChatGPT 3.5に少し劣るぐらいかなと思っていましたが、全然ダメですね。

単なる質問の回答もウソが多い、または、出力の文章量が少ない。

また、生成系の指示はほぼ無理ですね。

(xxxの文章を作成してとか、Pythonのプログラムを作成してとか)

「Advanced Configuration」で設定を少し変更できそうですが、今回は設定変更なしで検証。

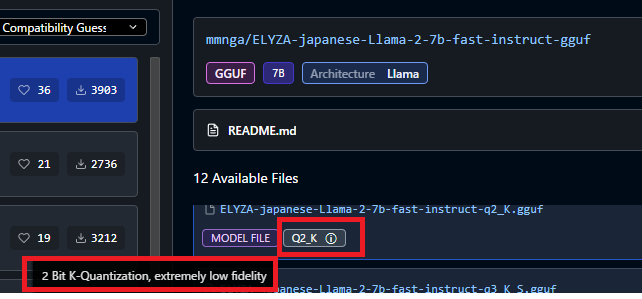

特に2ビット量子化されたものは、全然ダメです。

2ビット量子化されたモデルでは、まともに答えが返ってきません。

ELYZA-japanese-Llama-2-7b-fast-instruct-q2_K.gguf 2.89GB

6ビット量子化モデルで少し頑張っている感はありますが、回答としては全然不十分。

ELYZA-japanese-Llama-2-7b-fast-instruct-q6_K.gguf 5.62GB

最後に

回答の精度を上げるには、モデルのサイズも大きくなって、メモリも必要になってくるので、バランスが難しそうですね。

生成AIは日々進化しているので、定期的に確認していきたいと思います。

13BやAPI経由も試していこう。もっとメモリが大きなGPUが欲しいな。。

個人PCで試せるのはいいですね。

PythonプログラムでローカルLLMを使いたい方は以下をご覧ください。